Python: количество слов в строке

- 01.01.2024

- 484

- Основы Python

- Строки

Рассмотрим несколько методов подсчета слов в строке на Python, оценим их преимущества и недостатки. Мы начнем с базового подхода, используя стандартные функции языка, и постепенно перейдем к более сложным методам, включая использование регулярных выражений, а также специализированных библиотек, таких как NLTK и pandas. Это даст нам полное представление о доступных инструментах и поможет выбрать наиболее подходящий способ в зависимости от конкретных требований задачи и контекста ее использования.

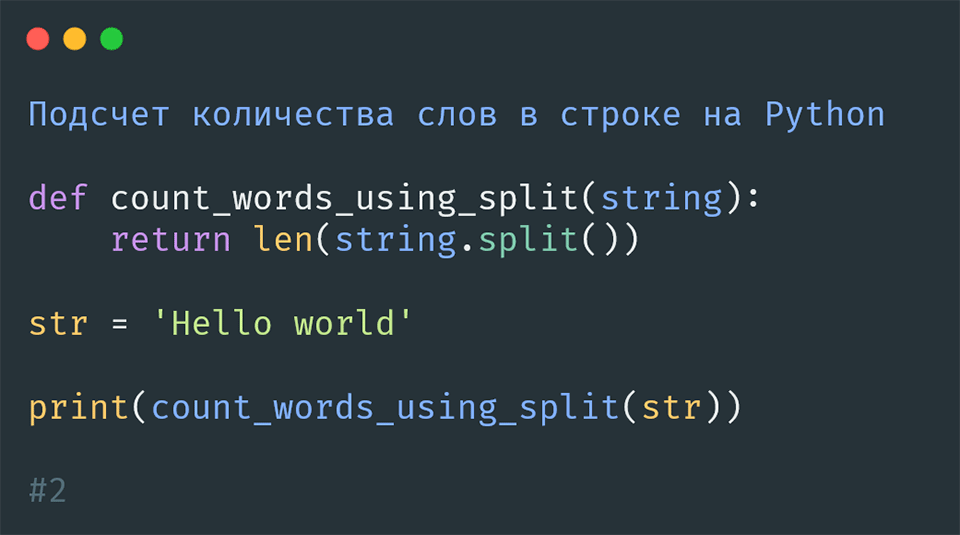

Использование метода split()

def count_words_using_split(string):

return len(string.split())

str = 'Hello world'

print(count_words_using_split(str))

#2Преимущества:

- Простота и читаемость кода.

- Не требует внешних библиотек.

Недостатки:

- Работает только для стандартных разделителей слов (пробелы, табуляции).

- Может давать неверные результаты, если в строке есть специальные символы.

Использование регулярных выражений (Regex)

import re

def count_words_using_regex(string):

return len(re.findall(r'\b\w+\b', string))

str = 'Hello world'

print(count_words_using_regex(str))

#2Преимущества:

- Гибкость в определении слов (можно настроить для различных языков и символов).

- Хорошо справляется со специальными символами и знаками препинания.

Недостатки:

- Сложнее в освоении для новичков.

- Может быть медленнее, чем простой метод split.

Использование библиотеки NLTK

from nltk.tokenize import word_tokenize

def count_words_using_nltk(string):

return len(word_tokenize(string))

str = 'Hello world'

print(count_words_using_nltk(str))

#2Преимущества:

- Очень точный подсчет слов, особенно для сложных текстов.

- Подходит для обработки естественного языка.

Недостатки:

- Требует установки дополнительных библиотек.

- Больше затрат ресурсов, чем простые методы.

Использование библиотеки pandas для анализа данных

import pandas as pd

def count_words_using_pandas(string):

return pd.Series(string.split()).count()

str = 'Hello world'

print(count_words_using_pandas(str))

#2Преимущества:

- Интеграция с библиотекой pandas, полезной для анализа данных.

- Удобно при работе с большими наборами данных.

Недостатки:

- Избыточно для простой задачи подсчета слов.

- Требует установки pandas, что может быть лишним для небольших проектов.

Заключение

Выбор метода зависит от конкретных требований задачи. Для простых случаев достаточно использовать split(), но при работе с большими или сложными текстами лучше подходит NLTK или регулярные выражения. В контексте анализа данных удобно использовать pandas. Каждый метод имеет свои сильные и слабые стороны, и выбор зависит от специфики задачи и предпочтений разработчика.

Содержание: