Экспорт парсигна BeautifulSoup в файл

- 25.11.2023

- 910

- Библиотеки Python

- BeautifulSoup

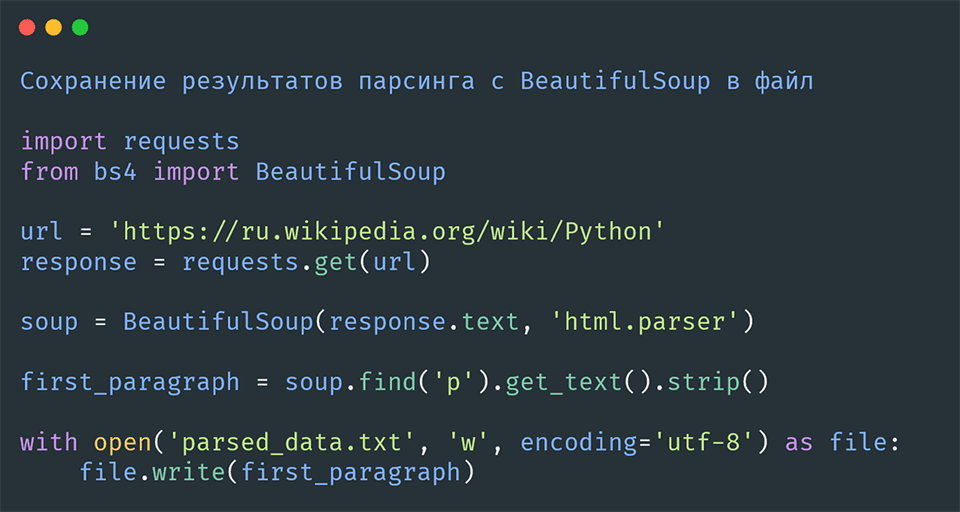

Рассмотрим, как можно спарсить данные с веб-страницы и сохранить их в файл, используя Python и его библиотеки BeautifulSoup и open. В качестве примера мы спарсим первый абзац со страницы Википедии о Python и сохраним его в текстовый файл.

Шаг 1: Парсинг веб-страницы

Для начала нам необходимо извлечь данные с веб-страницы.

Импорт библиотек:

Для начала нам понадобится импортировать библиотеки requests для отправки HTTP-запросов и BeautifulSoup для парсинга HTML.

import requests

from bs4 import BeautifulSoupОтправка запроса и получение HTML-кода:

Отправим запрос на страницу Википедии и получим HTML-код страницы.

url = 'https://ru.wikipedia.org/wiki/Python'

response = requests.get(url)Парсинг HTML-кода:

Используем BeautifulSoup для анализа полученного HTML-кода.

soup = BeautifulSoup(response.text, 'html.parser')Извлечение первого абзаца:

Теперь найдем и извлечем первый абзац из HTML-кода.

first_paragraph = soup.find('p').get_text().strip()Шаг 2: Сохранение данных в файл

Теперь, когда у нас есть спарсенные данные, мы можем сохранить их в файл.

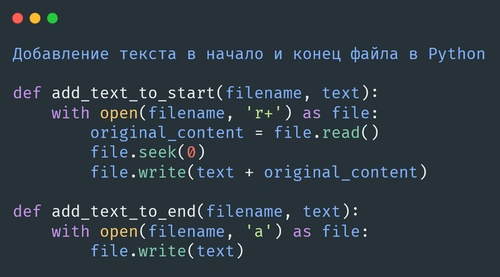

Использование встроенной функции open():

Для записи данных в файл используем встроенную функцию open(). Эта функция позволяет открыть файл для чтения r, записи w, добавления a или для чтения и записи r+.

Запись данных в файл:

Откроем файл в режиме записи и запишем в него данные.

with open('parsed_data.txt', 'w', encoding='utf-8') as file:

file.write(first_paragraph)Используем контекстный менеджер with для гарантии корректного закрытия файла после записи. Параметр encoding='utf-8' обеспечивает корректную обработку текста.

Шаг 3: Чтение данных из файла

После сохранения данных вы можете также прочитать их из файла.

with open('parsed_data.txt', 'r', encoding='utf-8') as file:

content = file.read()

print(content)Этот код откроет файл для чтения и выведет его содержимое на экран.

Заключение

Теперь вы знаете, как с помощью Python, BeautifulSoup и встроенной функции open() спарсить данные с веб-страницы и сохранить их в файл, а также как их затем прочитать. Эти навыки полезны для различных задач, связанных с веб-скрапингом и обработкой данных.

Содержание: