Экспорт данных парсинга BeautifulSoup в Excel и csv через pandas.

- 26.11.2023

- 832

- Библиотеки Python

- BeautifulSoup

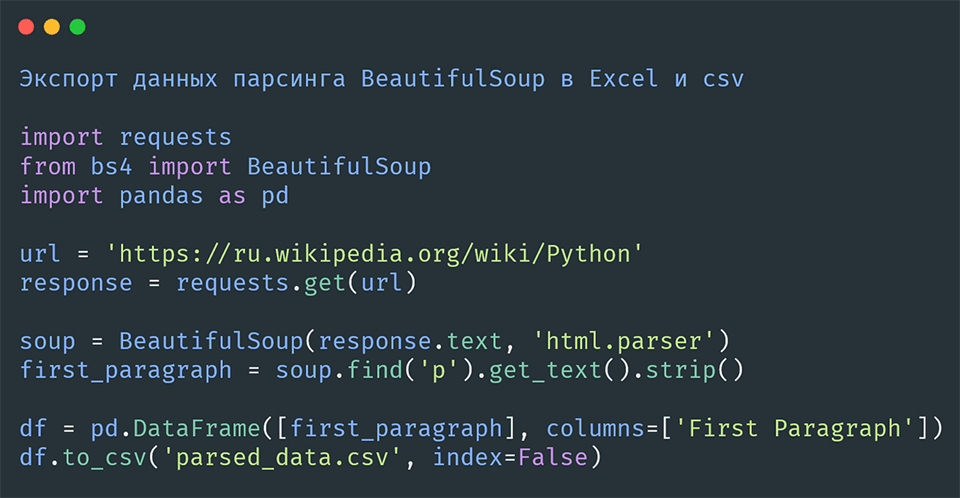

Рассмотрим, как сохранить результат вашего парсинга с помощью библиотеки BeautifulSoup в Excel и CSV, через библиотеку Pandas.

Шаг 1: Парсинг данных с веб-страницы

Для начала давайте спарсим первый абзац со страницы Википедии о Python.

Импорт необходимых библиотек:

Вам понадобятся библиотеки requests для получения HTML-кода страницы и BeautifulSoup из bs4 для анализа и извлечения данных.

import requests

from bs4 import BeautifulSoupЗапрос к странице:

Отправляем GET-запрос к URL, чтобы получить HTML-контент страницы.

url = 'https://ru.wikipedia.org/wiki/Python'

response = requests.get(url)Использование BeautifulSoup:

Используем BeautifulSoup для парсинга HTML-кода.

soup = BeautifulSoup(response.text, 'html.parser')Извлечение первого абзаца:

Находим первый абзац <p> в теле статьи.

first_paragraph = soup.find('p').get_text().strip()Шаг 2: Работа с библиотекой pandas для сохранения данных

Импорт pandas:

Для работы с таблицами и сохранения данных в форматы Excel и CSV используем библиотеку pandas.

import pandas as pdСоздание DataFrame:

Создаем DataFrame из спарсенных данных. В нашем случае это будет таблица с одной строкой и одним столбцом, содержащим первый абзац.

df = pd.DataFrame([first_paragraph], columns=['First Paragraph'])Шаг 3: Экспорт данных в форматы Excel и CSV

Сохранение в формате CSV:

Используем метод to_csv() для сохранения DataFrame в файл CSV.

df.to_csv('parsed_data.csv', index=False)Здесь index=False указывает на то, что индексы не будут сохранены в файле.

Сохранение в формате Excel:

Для сохранения данных в формат Excel используем метод to_excel(). Это требует наличия библиотеки openpyxl.

df.to_excel('parsed_data.xlsx', index=False)Аналогично, index=False предотвращает сохранение индексов в файле.

Заключение

Теперь у вас есть базовое понимание того, как извлечь данные из веб-страницы с помощью BeautifulSoup и сохранить их в форматах Excel и CSV с помощью pandas. Эти навыки могут быть полезны для множества задач анализа данных, автоматизации и сбора информации.

Содержание: